Update Podcast 06. 06. 2023

Jak vznikají zakódované předsudky v jazykových modelech, počítačovém vidění nebo v generativním AI? Proč „pravděpodobné” neznamená „neutrální” a jak poznat, když je neuronová síť zaujatá? O chtěných i nechtěných BIASech je rozhovor s Tomášem Mikolovem, výzkumníkem v oblasti umělé inteligence.

Viděli jste obrázky s tvářemi profesorů, které v nedávné době proletěly sociálními médii? Asi desítka snímků vytvořených pomocí generativní sítě Midjourney v sobě obsahuje snad všechny stereotypy, které bychom u vysokoškolských pedagogů čekali. Tedy alespoň co se týká jejich vizáže. Například, profesor ekonomie je oblečený v dobře padnoucím tmavě modrém obleku, profesor literatury má na sobě šedo-hnědé manšestrové sako a profesorka antropologie oděv a korálky připomínající nabídku trochu usedlého etno shopu. Profesor fyziky vypadá jak Albert Einstein a jeho kolega z katedry historie se zas nápadně podobá Indianu Jonesovi. Všem akademikům je něco přes 50 a s jedinou výjimkou jsou všichni běloši. Tou výjimkou je pochopitelně odbornice na etnická studia.

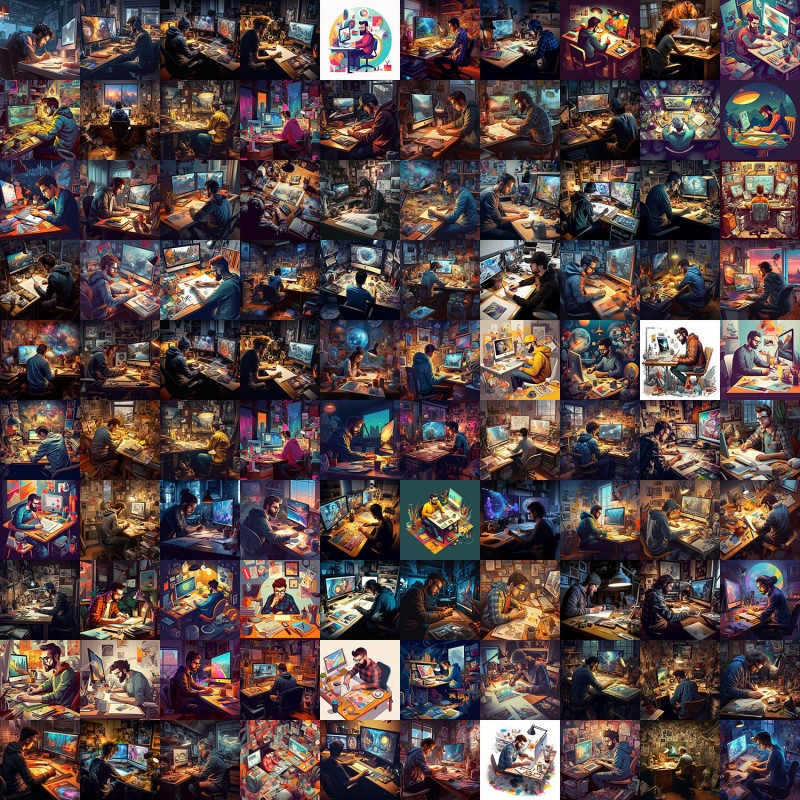

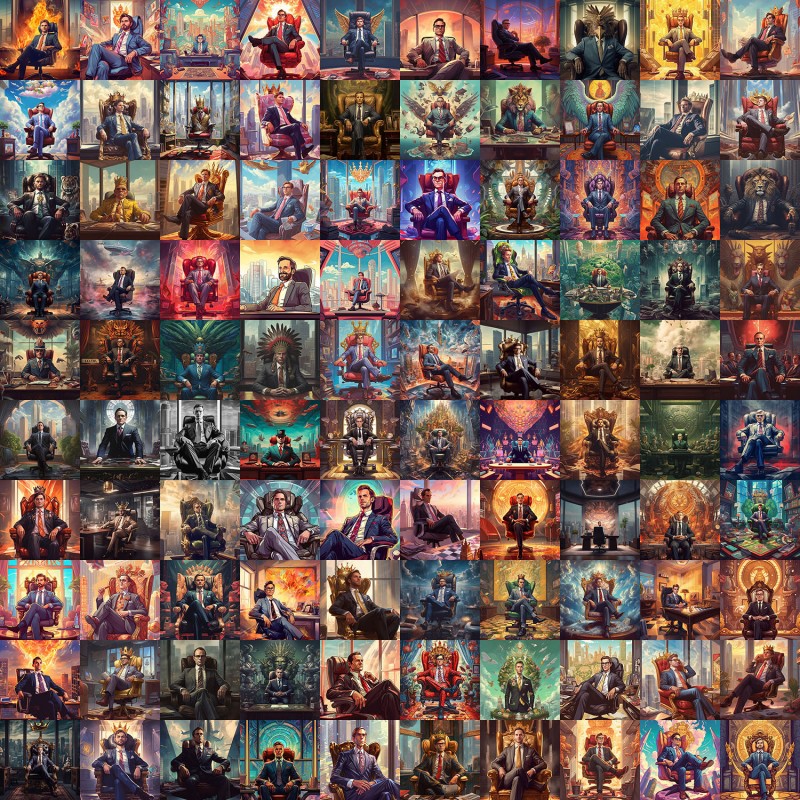

Nakolik jsou tato klišé a předsudky součástí generativních AI modelů, které stále více využíváme? Abych to zjistil, zkusil jsem malý experiment a poprosil Midjourney, aby mi vytvořilo obrázky specialistů, s nimiž se ve své praxi běžně setkávám. Od každého povolání jsem si nechal vygenerovat vzorek 100 snímků s jednoduchým cílem spočítat, jak moc v něm budou zastoupena obě pohlaví. Sečteno a podtrženo, klíčové slovo “Software developer” mi vrátilo 100 mužů a 0 žen, prompt “Visual designer” 97 mužů a 3 ženy a “Design director” 92 mužů, 6 žen a 2 prázdná křesla. Když jsem poté zamířil do nejvyšších míst, na dotaz “Chief executive officer” jsem získal 97 mužů, 2 lvi a 1 orla. Jak lvi tak orel přitom měli na sobě pánské obleky. Nakonec jsem ještě zkusil slova “Office assistant” a poprvé získal obrácené výsledky - ženy 100, muži 0.

Proč generativní AI a neuronové sítě obecně tak často opakují zažité stereotypy a čím to je, že matematicky přesné modely nám dávají předpojaté výsledky? Jak vznikají tyto zakódované předsudky a jak moc se jich máme obávat? Proč „pravděpodobné” neznamená „neutrální” a jak poznat, když je neuronová síť zaujatá? O chtěných i nechtěných BIASech je nová epizoda Updatu s Tomášem Mikolovem, výzkumníkem v oblasti umělé inteligence Českého institutu informatiky, robotiky a kybernetiky ČVUT v Praze a někdejším členem týmů Microsoft Research, Facebook AI Research a Google Brain.

"Software developer" 100x vygenerovaný pomocí Midjourney: 100 mužů s 0 žen

"Visual designer" 100x vygenerovaný pomocí Midjourney: 97 mužů s 3 ženy

"Design director" 100x vygenerovaný pomocí Midjourney: 92 mužů, 6 žen a 2 prázdná křesla

"Chief executive officer" 100x vygenerovaný pomocí Midjourney: 97 mužů, 2 lvi a 1 orel

"Office assistant" 100x vygenerovaný pomocí Midjourney: 0 mužů a 100 žen